Các Bước Thực Tiễn Để Chạy Các Mô Hình LLM Mở Mới Nhất Trên macOS Của Bạn

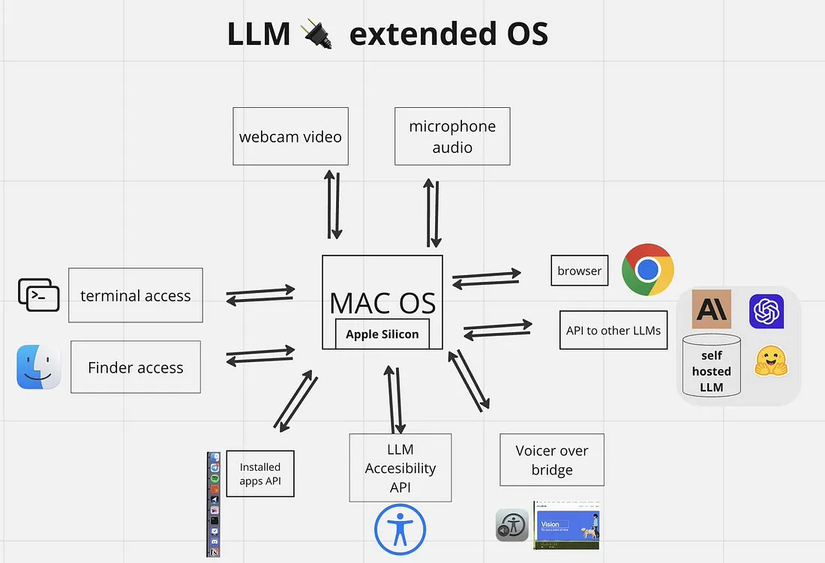

Thế giới của các Mô Hình Ngôn Ngữ Lớn (LLM) hiện nay đang thật sự rất hấp dẫn, phải không? Mỗi tuần dường như lại có những mô hình mới, những khả năng mới và những làn sóng phấn khích không ngừng. Cơn sốt không thể phủ nhận. Tuy nhiên, với những nhà phát triển, đặc biệt là những người làm việc trên macOS, điều thú vị thực sự là khi chúng ta có thể vượt qua cơn sốt và bắt đầu áp dụng thực tế các công cụ mạnh mẽ này vào dự án của mình — riêng tư, tiết kiệm chi phí và trên chính máy của mình.

Việc chạy các mô hình LLM mở hàng đầu ngày nay trên máy tính của bạn không chỉ còn là một điều thú vị nữa; nó đang trở thành nền tảng của sự phát triển sáng tạo, từ trợ lý lập trình tiên tiến đến việc xây dựng những ứng dụng AI hoàn toàn mới. Hướng dẫn này sẽ đưa bạn qua các bước thực tế để bắt đầu và giới thiệu một "môi trường phát triển mới" mà tôi đã tìm thấy, giúp đơn giản hóa quy trình này rất nhiều trên macOS.

Tại Sao Lại Chạy LLM Locally Trên Máy Mac? (Một Lý Do Ngắn Gọn)

Trước khi đi vào “cách làm”, chúng ta cùng xem qua “tại sao” điều này lại hấp dẫn đến vậy, vì lý do này thực sự thuyết phục:

- Bảo mật là ưu tiên hàng đầu: Dữ liệu, yêu cầu và mã nguồn của bạn vẫn được giữ trên máy của bạn. Điều này là không thể thỏa hiệp đối với những dự án nhạy cảm.

- Không tốn phí API cho Inference: Thử nghiệm, lặp lại và chạy bao nhiêu truy vấn tùy thích mà không lo về hóa đơn API.

- Khả năng chạy offline: Trợ lý AI của bạn sẽ vẫn hoạt động ngay cả khi không có internet.

- Kiểm soát và tùy chỉnh toàn diện: Bạn hoàn toàn kiểm soát mô hình, môi trường và cách sử dụng.

- Độ trễ thấp: Trải nghiệm phản hồi nhanh chóng hơn so với nhiều API đám mây.

- Với các nhà phát triển trên macOS, với các chip M-series mạnh mẽ, hiệu suất LLM trên máy tính cá nhân ngày càng ấn tượng.

Các "Ứng Cử Viên Hàng Đầu Ngày Nay": Những Mô Hình LLM Mở Để Phát Triển Locally Trên macOS Năm 2025

Cảnh quan LLM mở hiện nay rất năng động. Tính đến cuối tháng 5 năm 2025, một số dòng mô hình đang rất phổ biến cho việc phát triển locally trên Mac, thường được chạy thông qua công cụ như Ollama:

- Google’s Gemma Family (bao gồm các biến thể Gemma 3n mới nhất): Các mô hình này, từ phiên bản nhỏ và hiệu quả (như 2B hoặc ~3B mới) đến các mô hình mạnh mẽ hơn (ví dụ: 7B, và có thể là các phiên bản lượng tử hóa của các mô hình Gemma 3 lớn hơn), được khen ngợi về hiệu suất mạnh mẽ so với kích thước, đặc biệt là trên phần cứng của Google và với tối ưu hóa phần mềm tốt.

- Meta’s Llama Series (ví dụ: Llama 3 và các phiên bản mới): Các mô hình Llama đã đóng vai trò nền tảng trong việc dân chủ hóa quyền truy cập vào LLM mạnh mẽ. Llama 3, với các kích thước tham số khác nhau (8B, 70B, và có thể các phiên bản chuyên biệt mới hơn), cung cấp khả năng tổng quát tuyệt vời và là lựa chọn phổ biến cho việc tinh chỉnh và thử nghiệm.

- Mistral AI Models (ví dụ: Mistral 7B, Mixtral series): Được biết đến với hiệu quả và hiệu suất mạnh mẽ, đặc biệt là các mô hình "mixture of experts" như Mixtral.

- Microsoft’s Phi-3 Family: Các mô hình ngôn ngữ nhỏ (SLMs) như Phi-3 Mini, Small, và Medium đã gây ấn tượng với hiệu suất mạnh mẽ trong các kích thước nhỏ, khiến chúng lý tưởng cho môi trường local có tài nguyên hạn chế hoặc các nhiệm vụ cụ thể.

Danh sách này không đầy đủ, vì các mô hình và biến thể mới ra mắt rất nhanh, nhưng đây là một số cái tên chủ chốt bạn có thể muốn thử nghiệm locally.

Kế Hoạch Tổng Quan: Các Bước Thực Tiễn Để Chạy LLM Locally

Các bước cơ bản để bắt đầu chạy các mô hình này trên máy Mac của bạn thường bao gồm một vài bước chính:

-

Kiểm Tra Phần Cứng: Các máy Mac hiện đại, đặc biệt là những máy có chip M1/M2/M3 và RAM đủ (16GB trở lên cho nhiều mô hình, 32GB+ cho các mô hình lớn hơn), đều có khả năng chạy tốt.

-

Cài Đặt Công Cụ Chạy Mô Hình: Cách phổ biến và đơn giản nhất là sử dụng Ollama. Tải nó về từ trang web của họ và cài đặt.

-

Tải Mô Hình Bạn Chọn: Mở terminal và sử dụng lệnh như:

ollama pull llama3:8bhoặc ollama pull gemma:7b hoặc các tag mô hình khác.

-

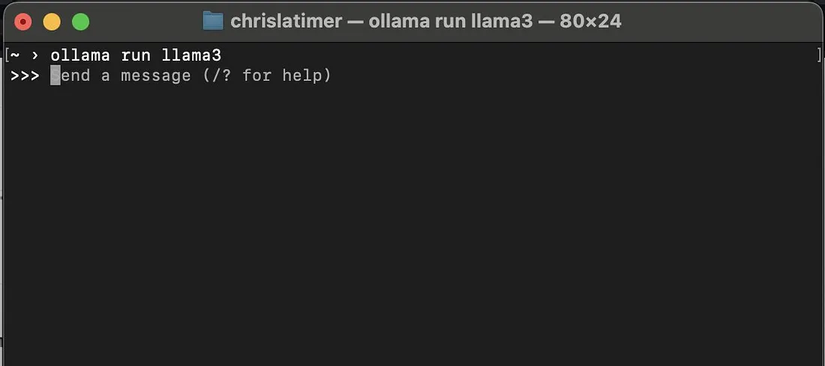

Tương Tác Cơ Bản (CLI): Sau khi tải về, bạn có thể chạy mô hình trực tiếp trong terminal của mình:

ollama run llama3:8b >>> Your prompt here... -

Thiết Lập Môi Trường Dự Án (Nếu Xây Dựng Ứng Dụng): Nếu bạn đang xây dựng ứng dụng tương tác với LLM, bạn sẽ cần một môi trường chuyên dụng cho mã của mình (ví dụ: Python hoặc Node.js). Điều này thường bao gồm:

- Tạo môi trường ảo (ví dụ:

python3 -m venv .venv và source .venv/bin/activate). - Cài đặt thư viện cần thiết (

pip install ollama requestscho Python, hoặcnpm install ollamacho Node.js). - Viết mã của bạn để tương tác với API local của Ollama (thường tại

http://localhost:11434).

- Tạo môi trường ảo (ví dụ:

Cách Tìm Giải Pháp: Một Môi Trường Phát Triển Mới Để Đơn Giản Hóa Mọi Thứ — Khám Phá ServBay

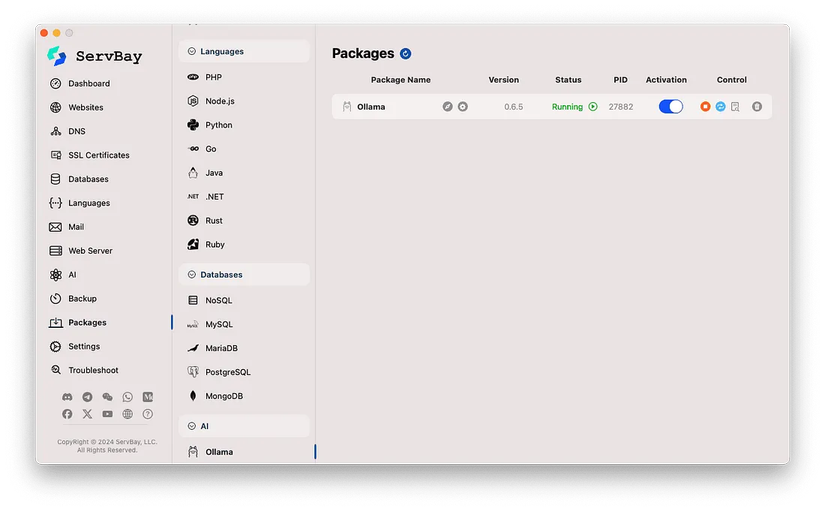

Trong quá trình phát triển AI trên máy Mac của mình, tôi đã tìm kiếm một cách để quản lý không chỉ Ollama mà toàn bộ môi trường phát triển local của mình. Tôi muốn một công cụ Mac-native có thể xử lý các phiên bản Python, Node.js, cơ sở dữ liệu và máy chủ web, tất cả đều tương thích tốt với Ollama. Và đó là lúc tôi phát hiện ra ServBay.

Ban đầu, tôi biết đến ServBay như một môi trường server all-in-one tuyệt vời cho các nhà phát triển web — lý tưởng cho PHP, Node.js, Python và quản lý cơ sở dữ liệu như MySQL và PostgreSQL với giao diện GUI sạch sẽ. Nhưng khoảnh khắc "aha!" thực sự đến khi tôi phát hiện ra tính năng tích hợp Ollama liền mạch của nó.

Kết Luận

Cơn sốt LLM thật sự hấp dẫn, nhưng cuộc cách mạng thực sự đối với nhiều nhà phát triển là khi chúng ta có thể đưa sức mạnh đó vào công việc hàng ngày của mình một cách hiệu quả và riêng tư. Những công cụ như Ollama đã làm cho việc truy cập các mô hình này trên máy Mac trở nên dễ dàng hơn bao giờ hết. Và khi bạn kết hợp điều đó với một công cụ quản lý môi trường phát triển đầy đủ như ServBay, con đường từ “cơn sốt” đến phát triển AI local thực tế, mạnh mẽ và riêng tư trở nên vô cùng mượt mà.

Tôi đã thử và bạn cũng có thể làm như vậy!

All rights reserved